La mise en œuvre d’une démarche qualité dans un établissement suppose de définir au préalable les informations à collecter et d’élaborer les indicateurs appropriés.

Au sein du SCD de Rouen, la démarche qualité a été initiée dès 2010 avec la mise en œuvre de l’accélérateur Amélioration de l’accueil Marianne. En septembre 2011, un groupe de travail dédié à la question de l’évaluation est constitué afin de répondre à trois objectifs :

- mener le projet d’enquête LibQUAL+

- mettre en œuvre des enquêtes « semaine test » de façon à fournir une statistique manquante à l’ESGBU1

- élaborer des indicateurs inscrits dans un tableau de bord pour servir d’outil d’aide au pilotage.

La participation du responsable informatique à ce groupe se révélera un élément important, qu’il s’agisse du travail accompli sur le SIGB, de la connaissance transverse développée au sein du SCD ou des propositions de solutions techniques adaptées aux problématiques rencontrées. La présence du contrôleur de gestion de l’université s’avèrera également fondamentale pour accompagner la démarche d’évaluation au niveau, plus global, de l’université.

Fiabiliser les statistiques

La mise en place d’une démarche d’évaluation passe par plusieurs phases : contrôle de la fiabilité des statistiques et étude approfondie des méthodes de collecte ; élaboration d’indicateurs et d’un tableau de bord adapté ; évaluation du niveau de satisfaction et des besoins des usagers.

Les statistiques de base d’un SCD reposent essentiellement sur son SIGB. Or, si les modules de description et de prêt des documents sont généralement parfaitement construits, le module statistique, ainsi que le module de description des usagers, en constituent le maillon faible. Ces deux modules sont pourtant particulièrement importants, tant pour contrôler la volumétrie de la fourniture de documents que pour élaborer une politique documentaire adaptée, ce qui nécessite une excellente connaissance des publics desservis.

Dans ce contexte, le module statistique du SIGB de Rouen a subi un profond nettoyage. Outre le fait que la durée de la phase d’inscription des nouveaux étudiants a été considérablement réduite grâce à l’import des données d’inscription à partir de la base Apogée, le formulaire comporte désormais, sous forme de listes déroulantes, une série de nouveaux champs pour mieux définir le profil des lecteurs. Trois champs supplémentaires ont été ajoutés afin de disposer de statistiques plus précises et plus fiables : la liste des établissements d’inscription ou UFR, la liste des diplômes, la liste des disciplines, basée, en raison de sa stabilité, sur celle des départements d’inscription des étudiants (liste utilisée aussi dans l’enquête LibQUAL+).

Parmi les outils de collecte des statistiques, le portique d’entrée de la bibliothèque fournit l’exemple même du chiffre dont la fiabilité devrait être incontestée, mais dont l’usage et l’interprétation varient pourtant d’une bibliothèque à l’autre pour différents motifs. Pour résoudre ces variations et disposer d’un outil de suivi détaillé, la mise à disposition d’un calendrier sous Excel destiné à la saisie quotidienne du relevé brut du compteur, en uniformisant la méthode, aide à venir à bout de cette liberté de choix, incompatible avec la rigueur comptable.

Pour compléter le dispositif, l’enquête « semaine test » a pour objectif de collecter manuellement le nombre des consultations sur place pendant une semaine. Réalisée deux fois par an, en juin et début décembre, cette enquête donne lieu à un rapport statistique qui tend à s’étoffer en fin d’année en compilant l’essentiel des statistiques de l’année écoulée.

La présentation du rapport aux membres du groupe de travail a offert l’occasion de réfléchir à la notion d’évaluation : ainsi, le modèle du rapport de la « semaine test » a fait l’objet d’une analyse collective, en vue de son amélioration et de sa complétude.

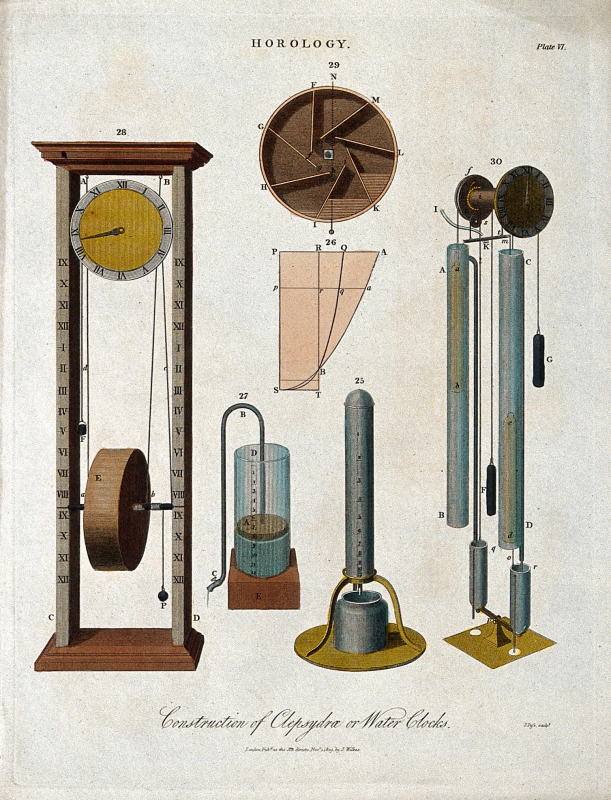

Horloges à eau – Gravure de J. Pass, 1809

© Wellcome Collection. CC BY

La mise en place d’indicateurs

Le fait d’avoir été accompagné dans la démarche par le contrôleur de gestion de l’université a favorisé l’atteinte des objectifs attribués au groupe de travail. Outre l’introduction de la notion d’indicateur, le contrôleur de gestion a en effet fourni un modèle de fiche descriptive et aidé au choix des indicateurs les plus pertinents. Pour le groupe, l’intérêt de cette démarche portait principalement sur le fait de se mettre d’accord sur une méthodologie apte à définir les indicateurs et de produire un document qui serve de référence.

Les indicateurs proposés peuvent être catégorisés selon trois entrées : politique documentaire ; management ; pilotage des services offerts.

En fonction du contrat de plan État-région, deux périodes ont ainsi été couvertes (2012‑2015 et 2017‑2020). On notera qu’entre les deux périodes, la liste des indicateurs a été revue, certains indicateurs difficilement calculables ayant été écartés, d’autres ayant été précisés ou reformulés.

Côté outils, il a été jugé nécessaire de rassembler dans un endroit unique les statistiques éparpillées dans des dossiers informatiques partagés. Pour ce faire, un fichier Excel a été conçu et fait office de tableau de bord : dans un premier onglet, on trouve des statistiques par année ; dans un second onglet, les statistiques collectées à des périodes diverses ; dans un troisième onglet, le calcul automatique des indicateurs selon les formules inscrites dans les fiches descriptives de chaque indicateur. Ce tableau de bord est devenu le document de référence du SCD pour retrouver les statistiques utiles. Il est utilisé notamment pour l’élaboration de la politique documentaire ou la rédaction du rapport annuel.

Bien entendu, le système d’indicateurs ainsi construit peut être remis en question : la liste des indicateurs doit-elle se baser uniquement sur l’ESGBU ? En quoi l’enquête réalisée par l’ADBU sur les indicateurs européens peut-elle enrichir notre réflexion interne ? L’outil lui-même pourra évoluer vers une base de données web élaborée en fonction des indicateurs à calculer.

Toujours est-il que ce travail a été reconnu et généralisé à tous les services de l’université, sous la houlette avisée du contrôleur de gestion précédemment cité et de la responsable qualité de l’université, qui ont construit un tableau de bord à l’usage de la présidence.

De l’évaluation des services aux usagers à la mesure de leur impact

Le service rendu aux usagers des bibliothèques universitaires de Rouen est évalué à intervalles réguliers. Ainsi, deux enquêtes LibQUAL+ ont été menées en 2012 et 2015 afin d’évaluer le niveau de satisfaction des usagers. Ces enquêtes ont apporté un ensemble d’informations intéressant, et très précis grâce aux commentaires. Les étudiants comme les enseignants ont pris l’habitude d’être interrogés, et le niveau de participation est toujours suffisant pour une bonne exploitation des données. Une troisième enquête, coordonnée par la ComUE Normandie Université2, est programmée en 2020.

Suite à l’enquête menée fin 2018, avec pour objectif de cerner le profil du public sur place dans chaque bibliothèque et l’usage des services offerts, complété d’une cartographie précise des usagers fréquentant les BU lors de la semaine test, des pistes d’évolution ont été ouvertes. Le groupe de travail projette de mener d’autres enquêtes afin d’affiner la connaissance des besoins des usagers… et leur degré de satisfaction. Par ailleurs, le fait que la responsable de la mission transverse « Évaluation et démarche qualité » soit impliquée dans le fonctionnement d’une bibliothèque du SCD a été bien utile pour repérer les dysfonctionnements d’organisation, d’outils ou les informations lacunaires sur le terrain. Dans le cadre des activités courantes de la bibliothèque, le rôle d’adjoint à la responsable de la BU Santé a fourni l’occasion d’évaluations au fil de l’eau. De fait, évaluer l’impact d’une politique menée par un SCD peut se traduire par une question posée en ces termes : les moyens affectés à ce projet ont-ils produit les effets escomptés ?

La mesure d’impact constitue un outil désormais essentiel de l’évaluation des politiques publiques, car il facilite des choix stratégiques d’affectation des moyens. Parmi les pistes de mesure sur l’impact de l’activité, on peut par exemple se demander si les moyens affectés par le SCD à la formation des étudiants ont un impact – ou non – sur la production de bibliographie de qualité3.

Deux conditions paraissent nécessaires : le travail d’évaluation doit avoir atteint un niveau de maturité en termes de méthode ; les équipes concernées doivent avoir intégré une culture de l’évaluation, de façon à accompagner la démarche avec la sincérité nécessaire à toute évaluation.

Un nouveau terrain de jeu

Au sein du SCD, l’évaluation a jusqu’alors été concentrée sur les activités du service. Dans une démarche de recherche d’efficacité accrue en fonction d’une situation aux moyens contraints, elle peut trouver un nouveau « terrain de jeu » pour ce qui concerne l’organisation du travail. Ainsi, depuis le lancement en 2017 d’une réorganisation interne du SCD de Rouen, la mission « Évaluation et démarche qualité » a évolué. Elle a tout d’abord rempli le rôle de support méthodologique pour la discussion avec le consultant, lors des séminaires puis, en collaboration avec l’équipe de direction, lors du processus de changement. Au terme d’une année de fonctionnement à plein régime, la mission est appelée maintenant à mener l’évaluation de cette nouvelle organisation fonctionnelle.